pluszero、「AEI」によりブラックボックスの見える化を実現 「AEI+ChatGPT」の組み合わせで信頼性向上へ

AEIとChatGPTの関係性

小代義行氏:みなさま、こんにちは。pluszero代表取締役会長兼CEOの小代です。本日は、「AEI(Artificial Elastic Intelligence)」と「ChatGPT」の関係性について、ご説明させていただきます。よろしくお願いいたします。

「AEI」と「ChatGPT」の関係性をご説明する前に、まず、みなさまにご理解いただきたいことがあります。「ChatGPT」や「GPT4」など、いろいろな言葉がありますが、厳密に言うと「ChatGPT」はサービス自体の名前で、「GPT4」はAIのモデルの1つということです。

資料中は「ChatGPT」に統一していますが、「大規模言語モデル」というホットなモデルを使ったサービス全般を指しています。したがって、「ChatGPT」とは言っていますが、類似するサービスはすべて含まれているくらいの気持ちで、お聞きください。

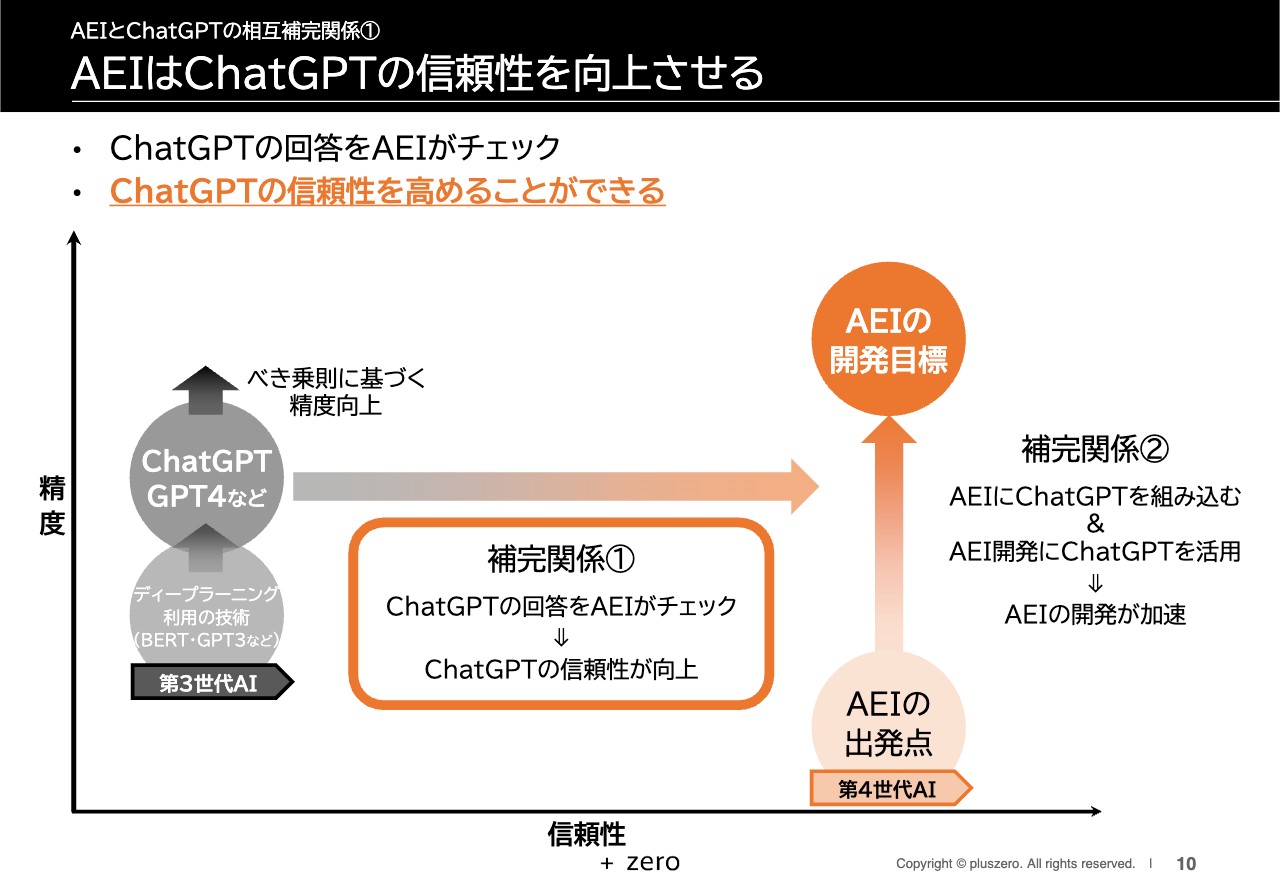

端的に言うと、「ChatGPT」は「AEI」にとって強烈な追い風になると思っています。具体的には2つの理由があります。1つ目は、「ChatGPT」と「AEI」が相互補完関係にあることです。スライドの図をご覧いただくと、「AEI」側からディープラーニング利用の技術(ChatGPT・GPT4等)に向かって矢印が出ています。これは「AEI」が「ChatGPT」の信頼性を向上させるということです。逆に「ChatGPT」は「AEI」の開発を加速させるということで、相互補完関係にあることを意味しています。

2つ目は、「AEI」が戦う「言語系AI」の市場可能性の高さを「ChatGPT」が世の中に認知させたことです。Microsoft社が多額の投資を決定し、文部科学省が国内の教育現場での活用を検討するといった話も出ています。

そのような意味で、非常にホットなモデルと考えており、「ChatGPT」は「AEI」にとって、強烈な追い風であると認識しています。

AEIとChatGPTの比較

スライドの表は「AEI」と「ChatGPT」の比較です。本日のご説明の最後に詳細をお話ししますが、このタイミングでみなさまにご理解いただきたいのは、「AEI」と「ChatGPT」は相互補完関係にあり、「AEI」単体よりも「ChatGPT」と組み合わせた「AEI+ChatGPT」のほうが、さらに価値が向上するということです。

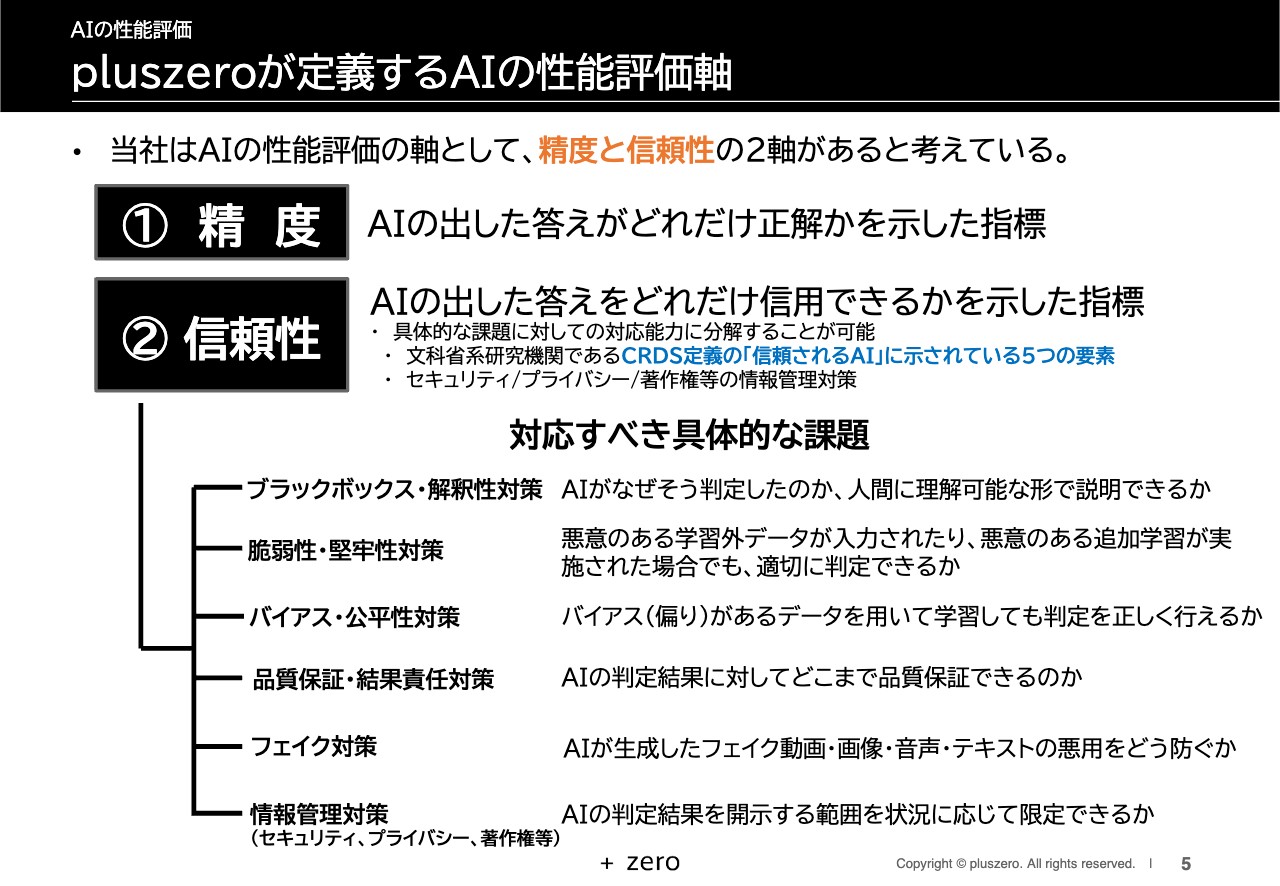

pluszeroが定義するAIの性能評価軸

当社は、AIの性能評価軸として、精度と信頼性の2軸があると考えています。精度とは、AIの出した答えがどれだけ正解かを示した指標で、信頼性とは、AIの出した答えをどれだけ信用できるかを示した指標です。

信頼性は、具体的な課題に対しての対応能力に分解できると思っており、「対処すべき具体的な課題」として、スライドには6項目を挙げています。

上から5つ目までの項目は、「信頼されるAI」を構成する要素として文部科学省系の研究機関である研究開発戦略センター(CRDS)が定義したものです。「ブラックボックス・解釈性対策」「脆弱性・堅牢性対策」「バイアス・公平性対策」「品質保証・結果責任対策」「フェイク対策」に対応していなければ信頼されないということで、AIの信頼性に関する文献でも、この5つの要素は共通しています。

6つ目の「情報管理対策」は、特にセキュリティやプライバシー、著作権管理です。AIの判定結果を開示する範囲を明確にするといった情報管理も重要だと考えています。

以上6項目の具体的な課題について、いかに対応していくかが信頼性を高めていくポイントです。非常に大事なことですので、それぞれご説明していきます。

「ブラックボックス・解釈性対策」は、中身が見えないという意味ではなく、AIがなぜそう判定したのかを、人間が理解可能なかたちで説明できるかどうかということです。

「脆弱性・堅牢性対策」は、悪意のある学習外のデータ入力がされたり、追加学習が実施されたりした場合に、学習範囲から外れたものがあっても適切に判定できるかということです。

「バイアス・公平性対策」についてです。AIは、基本的に学習に用いるデータが非常に重要です。データ自体にバイアス(偏り)があると、そこから学習してできたAI自体に偏りが出やすくなります。そのようなデータを用いても判定を正しく行えるのかということです。

「品質保証・結果責任対策」では、品質を保証できることや、結果責任をきちんと負うことがポイントです。

「フェイク対策」については、今の時代、コンテンツが本物か否かといった真贋判定ができることが非常に重要となりますので、そのようなものへの対応となります。

これら6つの具体的な課題について、しっかりと対応できることを信頼性として定義できると考えており、当社としては、精度と信頼性の2軸によりAIを評価することを常に意識しています。

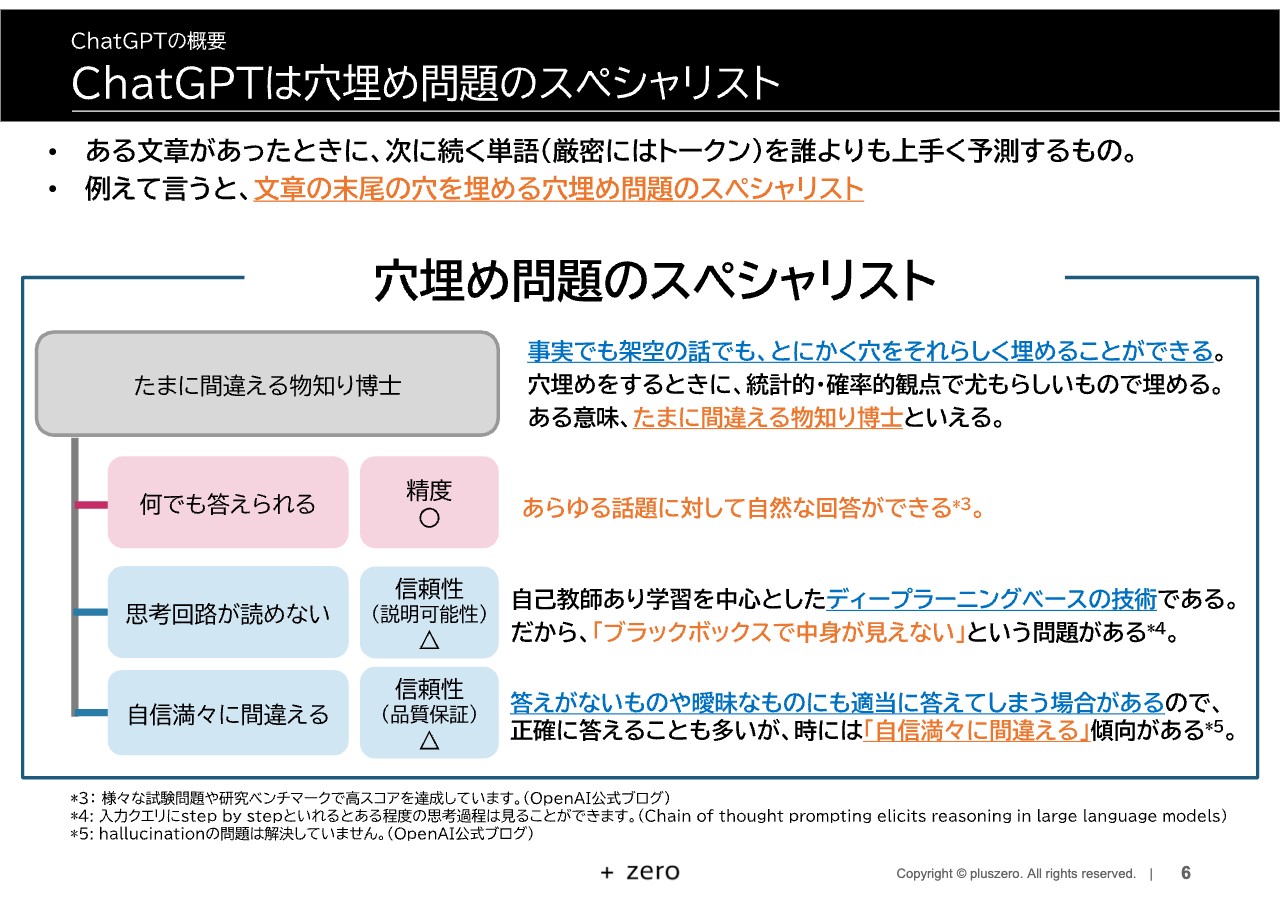

ChatGPTは穴埋め問題のスペシャリスト

「ChatGPT」を中心とした大規模言語モデルを一言で表すと「穴埋め問題のスペシャリスト」だと思います。ある文章の次に続く単語(厳密にはトークン)について、どのような単語が最もあり得るかということを大量のデータで学習したのが「ChatGPT」系のサービスや技術です。

文章の末尾の穴埋め問題を誰よりも上手く解けるということで、このように表現していますが、いくつか特徴がありますので、一つひとつご説明します。

1つ目は「何でも答えられる」ということです。世界中の大量のデータに基づいて、穴埋め問題を解けるように学習しているため、あらゆる話題に対して自然な回答ができます。そして精度が非常に高いことが挙げられます。実際に「OpenAI」の公式ブログでも、さまざまな試験問題や研究のベンチマークで高スコアを出しており、すばらしい結果だと思っています。

2つ目は「思考回路が読めない」ことです。専門用語となってしまいますが、「ChatGPT」は「自己教師あり学習」を中心としたディープラーニングベースの技術です。そのため、「ブラックボックスで中身が見えない」を人間に例えると、思考回路が読めないという問題になります。

最近では「ChatGPT」にどのような投げかけをすれば、求めているアウトプットが返ってくるかということで、入力欄(プロンプト)を工夫(エンジニアリング)することを考える人が多くなっています。入力欄に「step by step(一歩ずつしっかりと)」と加えると、ある程度の流れは確認できるようになっています。ただし、全体としての思考回路が読めないという要素が強い技術だと思っています。

3つ目は、「自信満々に間違える」ことです。専門用語で「ハルシネーション」と言いますが、「ChatGPT」は穴埋め問題のスペシャリストであるものの、答えがないものや曖昧なものは適当に答えてしまう傾向があります。正確に答えることも多いのですが、時には自信満々に間違えてしまうことが特徴です。

以上3点の「何でも答えられる」「思考回路が読めない」「自信満々に間違える」といった特徴を総括すると、「ChatGPT」は「たまに間違える物知り博士」と言えると思います。事実にせよ架空の話にせよ、とにかくそれらしく穴を埋められるということです。

統計的・確率的観点で穴埋めをする仕組みが、「たまに間違える物知り博士」を生み出しています。

ChatGPTの信頼性向上の試みと依然として残る課題

先ほどお伝えしたように、「ChatGPT」は自信満々に間違える傾向があり、思考回路が読めないため信頼性が課題になりやすく、解決の難易度は極めて高いです。一方で「ChatGPT」も、信頼性を高めるための独自の取り組みを行っています。スライドには、みなさまにご理解いただきたいポイントを2つお示ししています。

1つ目は、とにかく「人間視点で良い出力」になるように、しっかりと学習しているということです。具体的には、人間にとってより受け入れられやすい応答になるように、人間のフィードバックを使って強化学習しながら、本来のモデルをさらに洗練させています。

専門用語で「アラインメント」と言いますが、そのようなことをベースに、より人間に寄り添い、人間視点で良い出力になるように調整しています。

また、有害なコンテンツのフィルタリングについては、APIなどの出力にフィルタをかけることにより、有害なコンテンツが含まれているかを評価し、有害な動作を防いでいます。

フィルタをうまく回避して突破されないよう、入力欄に工夫を凝らし、内容に有害なものが含まれていないかをチェックする仕組みなども施しています。

現在、「ChatGPT」全体の信頼性の問題が話題になっていますが、「GPT4」の資料を見ると、チームを組んであらゆる対策を講じ、大変努力していることがわかります。

ChatGPTの未来は信頼性によって予測できる

今後、「ChatGPT」がどのようなかたちで普及していくのかを予測したものがこちらのスライドになります。スライド縦軸の「信頼性の必要性」は、上に行くほど信頼性が必要になるということです。横軸の「信頼性を補完する力」は、右に行くほど補完する力が強く、左に行くほど補完する力が弱くなります。

どのように普及していくのかということで、前向きなシナリオの1つ目は、信頼性が求められにくい領域で普及するとしています。エンタメやクリエイティブ領域、説明責任が問われにくい課題などがターゲットになります。

「ChatGPT」自体がブラックボックスなディープラーニングベースの技術です。信頼性に対する努力はしているものの課題がありますので、まずは信頼性が求められない領域で普及することが大切です。

2つ目は、「信頼性に問題はあるものの、信頼性をチェックできる人が使うのであれば問題ないのでは?」という発想です。信頼性を自らチェックできる人がアシスタント的に使うかたちで普及するというのが、前向きなシナリオだと考えています。

3つ目は、「AEI」という技術自体は信頼性を自動でチェックできるため、「AEI」だけではなく他の仕組みが出てきた時に、その仕組みと組み合わせて普及していくということです。

避けるべきシナリオとしては、信頼性を自らチェックできない人が、「楽だから」という理由で出力されたものを鵜呑みにして濫用してしまうことです。こちらは非常に問題があると思っています。

信頼性が求められにくい領域 ~前向きなシナリオ①の補足説明~

「前向きなシナリオ①」について補足説明します。1つ目は、アウトプットが出ること自体に価値があり、明確な精度の定義が難しいものです。

まずは、クリエイティブ領域である芸術・デザイン・エンターテインメントにおけるアウトプットです。精度という意味では、芸術にも良さを評価するポイントはあるため、必ずしも定義が難しいというのは言い過ぎかもしれません。一方で、創作し、アウトプットすること自体に非常に価値があるため、「ChatGPT」が活躍するポイントになると考えています。

またアイデアについては、アイデア出し自体に意味があり、ブレインストーミングなどにおいてはかなりの価値を創出すると考えています。もちろん著作権やプライバシー等を考慮する必要がありますが、あくまでも信頼性が問われにくいということで、まったく問われないわけではないとご理解いただければと思います。

2つ目は、説明責任(解釈性)や結果責任が問われにくい課題についてです。社会に悪影響がない範囲で使うということで、個人で閉じる場合や、社会と接点がある場合でも、ネット検索などの間違った答えが含まれることを織込済のケースです。

ネットの世界は玉石混交というか、役に立つものとそうではないものが混ざっていることを前提に検索されています。検索結果では有用なものから上位にランク付けされて出てくることはありますが、このような観点での活用は広がると思います。

また、精度が一定以上に高ければ、解釈性の部分が問われにくいケースで使われやすいと考えます。

AEIはChatGPTの信頼性を向上させる

冒頭で、「『AEI』と『ChatGPT』は相互補完関係にある」とお話ししました。これを、2つのステップに分けてご説明します。

まず、みなさまにご理解いただきたいことがあります。私たちは、「AEI」における2つの軸として、縦軸を精度、横軸を信頼性と定義しています。

「ChatGPT」の回答を「AEI」がチェックするという関係性に基づき、「ChatGPT」の信頼性を向上させることが補完関係の1段階目です。こちらを詳しくご説明します。

信頼性を高めるために必要なこと

信頼性を高めるために必要なことについてです。先ほど、信頼性の定義として5つの要素と情報管理についてご説明しましたが、そこで情報管理としてまとめていたものを、ここではセキュリティー、プライバシー、著作権の3つに分けています。

信頼性を高めるためには、スライドに記載している8つの具体的な課題に対処していくことが必要だと考えています。

「ブラックボックス・解釈可能性対策」の有効な打ち手は「見える化」のみで、ブラックボックスをホワイトボックスにすることが挙げられます。

「脆弱性・堅牢性対策」「バイアス・公平性対策」「品質保証・結果責任対策」などを考える上では、「フェイク対策」「セキュリティー対策」「プライバシー対策」「著作権対策」なども含めた「ルールとの適合性」、つまり、決まり・規則・法則に適しているかを見ることが有効です。

「フェイク対策」「セキュリティー対策」「プライバシー対策」「著作権対策」としては、本人・本物であるかを確認する「認証」が有効です。その上で、誰に何を出すかを制御する「アクセス制御」をしっかりと行う必要があると考えています。

そのような意味で、信頼性を高めるためには「見える化」「ルールとの適合性」「認証・アクセス制御」の3つが有効です。

ルールとの適合性をチェックする仕組みを作り、認証・アクセス制御をしっかり行うためには、ブラックボックスではなく見える化することで初めて有効になるという関係になっています。このようなことを一括りにして、私たちの技術である「AEI」で対策が可能となっています。

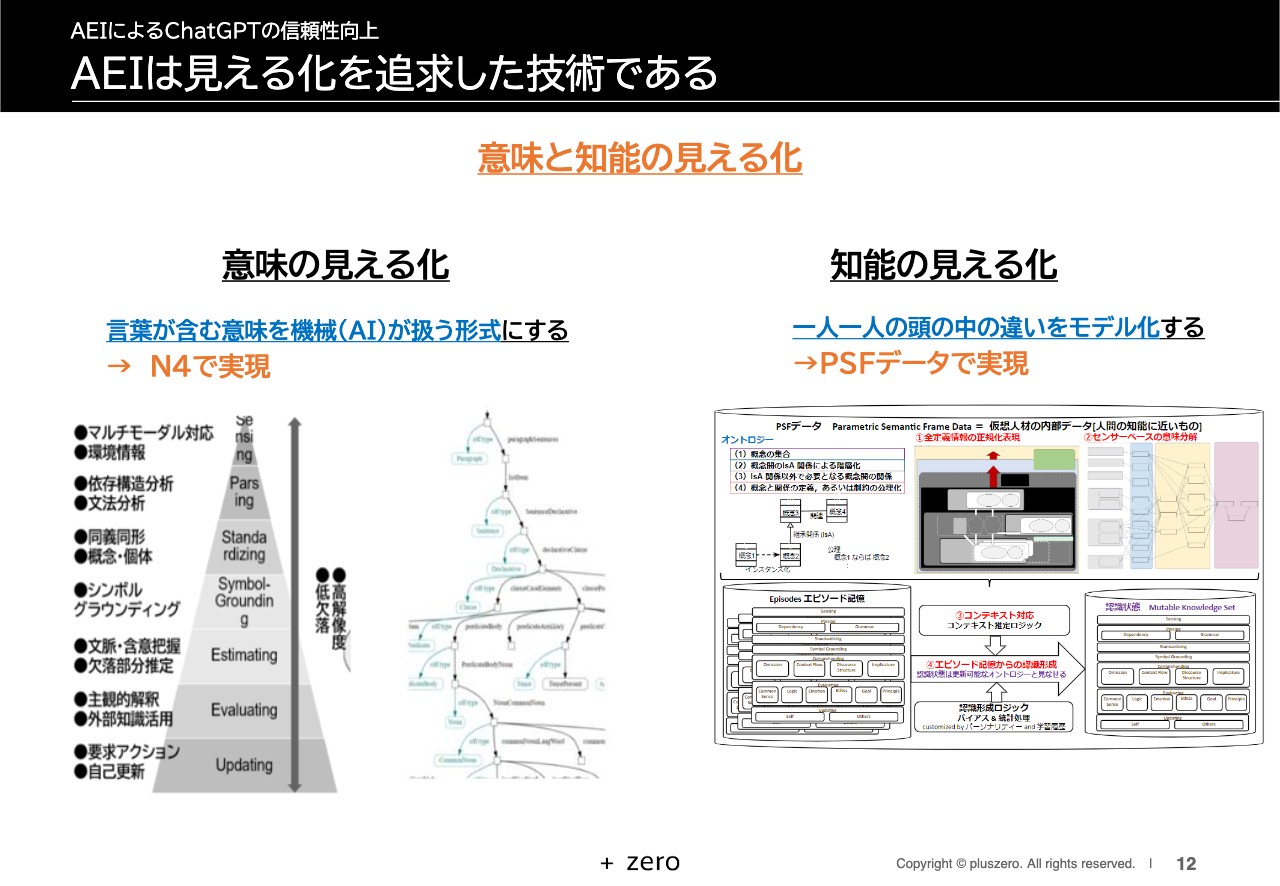

AEIは見える化を追求した技術である

「見える化」「ルールとの適合性」「認証・アクセス制御」の3つについて、個別にご説明します。

「AEI」は見える化を追求した技術です。ディープラーニング系の技術がブラックボックスであるのに対し、「AEI」は意味と知能の2つの面で見える化を徹底的に行っており、2021年9月時点で特許を取得しています。

まずは「意味の見える化」についてです。スライド左側に記載しているピラミッドは、レイヤー構造に一つひとつの層があり、層ごとに意味を捉えるように精密に設計されています。そのため、それぞれの言葉に含まれる意味が欠落せず、解像度も高まります。

その右側の図は、グラフ構造です。私たちの専門技術である「N4」により、このようなかたちで言葉が含む意味を保持し、機械(AI)が扱える形式にしています。

次に「知能の見える化」についてです。人間の一人ひとりの頭の中が違うように、「赤いリンゴ」という言葉1つとっても想起するものは異なります。そのため、AIをベースに知能を高度化していくには、一人ひとりの頭の中の違いも含め、可能な限りモデル化することが必要です。

私たちの技術である「PSFデータ」は、そのような知能の見える化を実現しています。「AEI」は、見える化を追求し、信頼性向上を図ることができる非常に特徴的な技術であるとご理解いただければと思います。

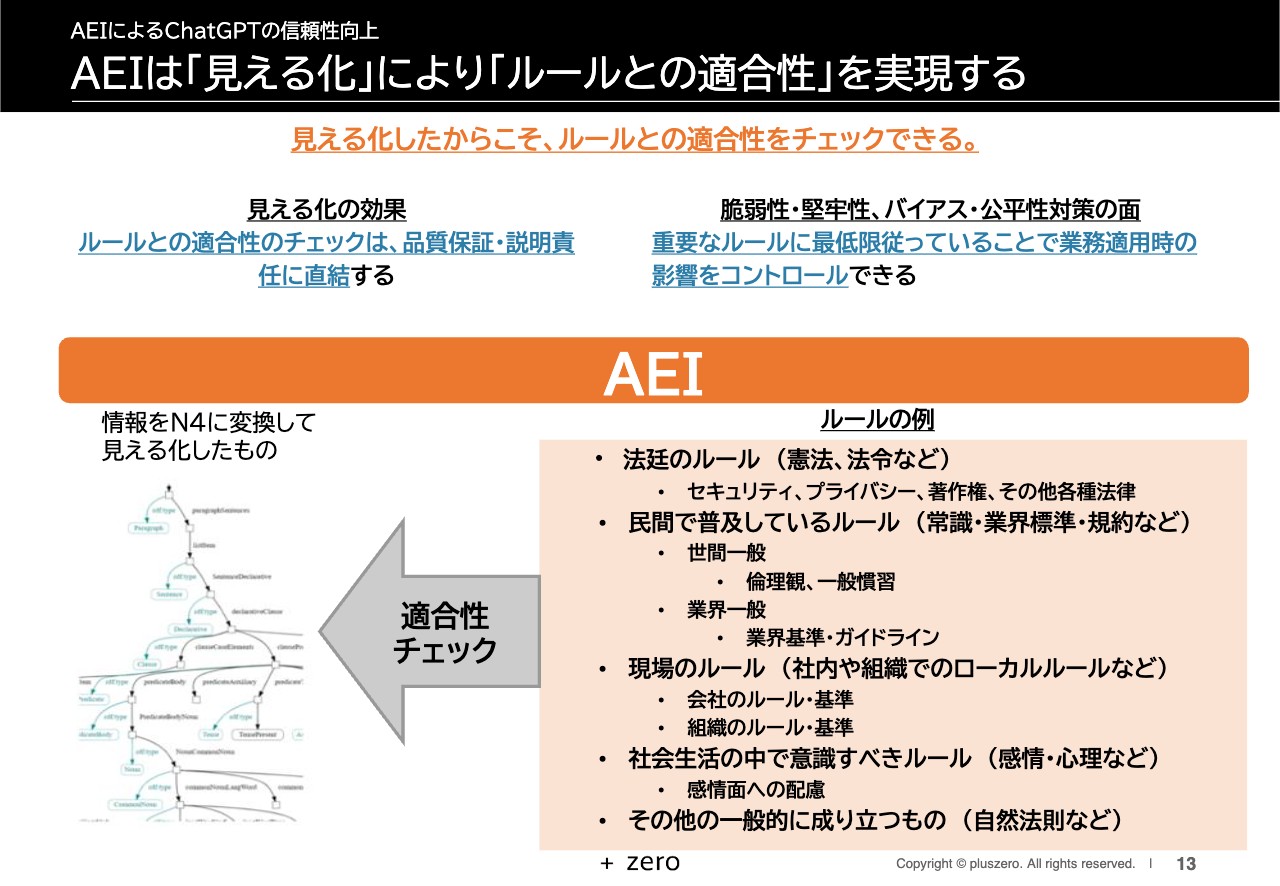

AEIは「見える化」により「ルールとの適合性」を実現する

「AEI」は「見える化」により「ルールとの適合性」を実現する技術です。見える化の効果として、ルールとの適合性のチェックは、品質保証・説明責任に直結します。当然のことながら、「ルールに従っていることはチェック済みですので、一定レベルの品質が保証できます」と言いやすくなります。

脆弱性・堅牢性、バイアス・公平性対策についてです。脆弱性・堅牢性では、学習した範囲外のものにどこまで対応できるかが、「ChatGPT」と「AEI」の両方にとっての課題です。

見える化した場合には、少なくとも重要なルールが明確化されます。それに従った範囲で業務に適用している場合は、未知の状況でもその重要なルールの中で対処できます。脆弱性や偏った事例のみが見えている場合でも、少なくとも重要なルールに従って動きを決められることは、信頼性を向上させる上で非常に有効です。

スライドの右側にルールの例として、「法廷のルール」「民間で普及しているルール」「現場のルール」「社会生活の中で意識すべきルール」「その他の一般的に成り立つもの」などを記載しています。

このようなチェックすべき対象を、私たちの「N4」という技術で変換し、見える化したものが実際にルールに適合しているかをチェックすることにより、信頼性を高めることができます。

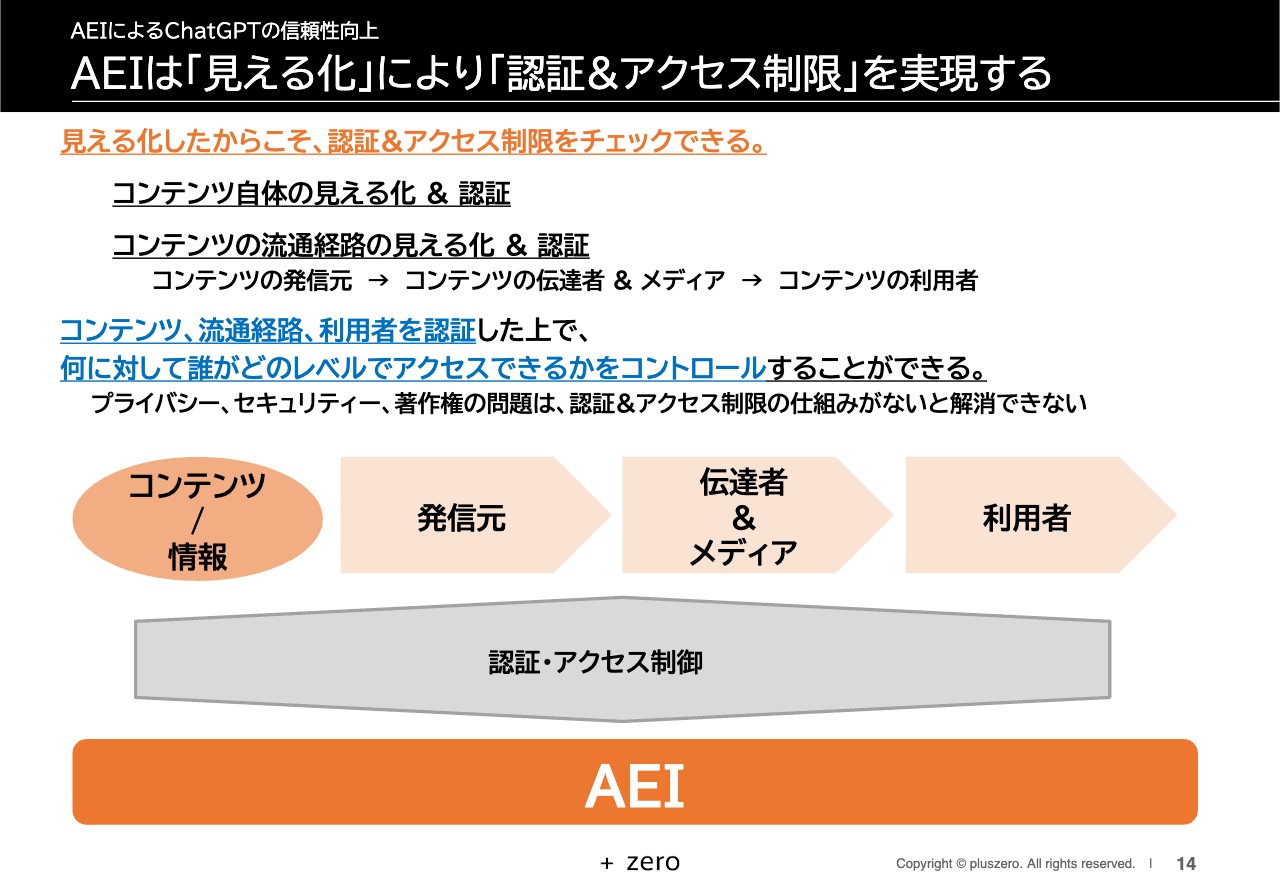

AEIは「見える化」により「認証&アクセス制限」を実現する

「認証・アクセス制限」についてです。コンテンツや情報自体が見える化され、誰が作り、どのように流通したのかを含め、本物であるかを確認できます。コンテンツに対して発信元、伝達者&メディア、利用者までの流通経路、利用者を認証した上で、それぞれのレベルでアクセスをコントロールする仕組みです。

認証・アクセス制限を行わなければ、プライバシー、セキュリティー、著作権の問題は解消できません。「AEI」は、この認証・アクセス制限を実現します。

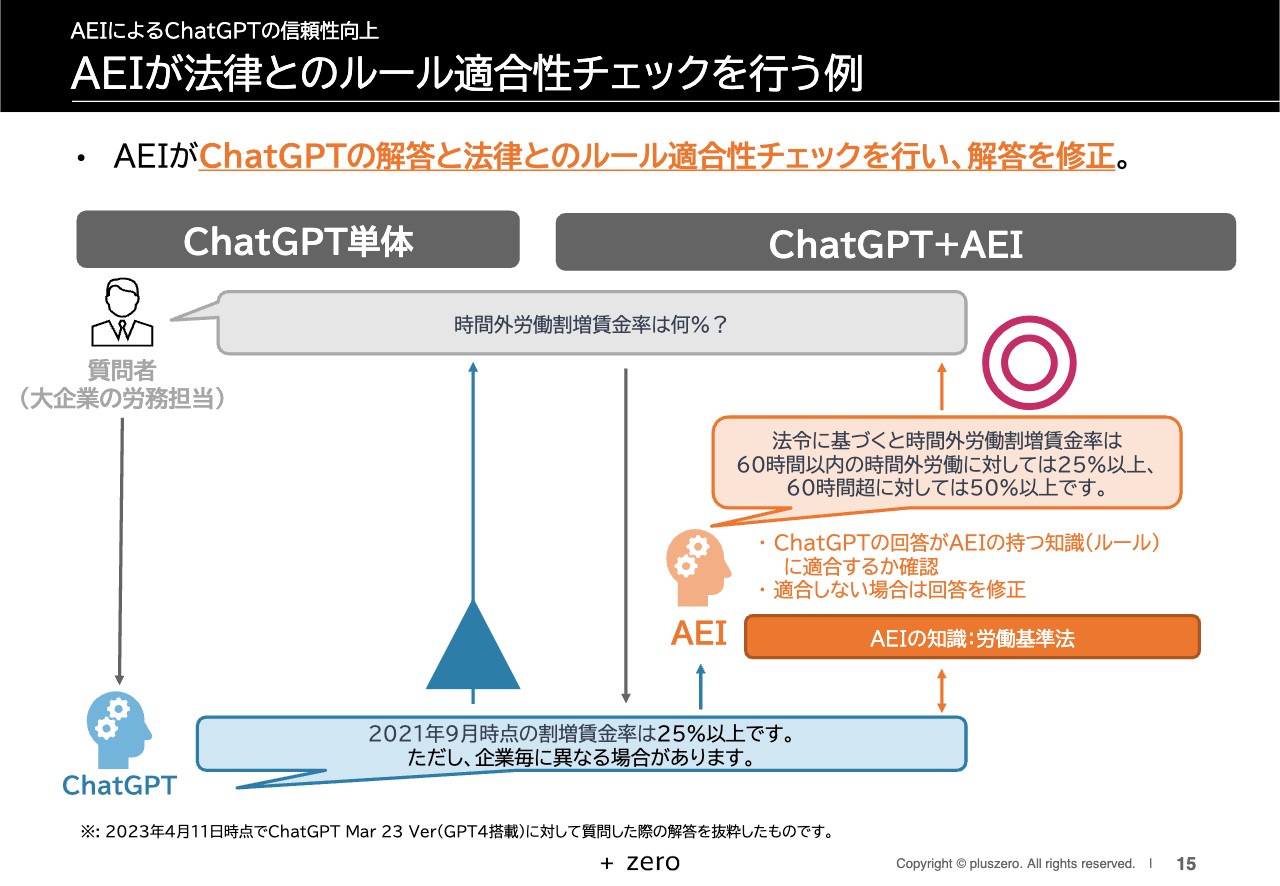

AEIが法律とのルール適合性チェックを行う例

「ChatGPT」単体と、「ChatGPT+AEI」の回答イメージの比較です。例えば、大企業の労務担当者が「時間外労働割増賃金率は何パーセント?」と質問します。

すると、2023年4月11日時点で、「GPT4」を搭載した「ChatGPT」は、「2021年9月時点の割増賃金率は25パーセント以上です。ただし、企業ごとに異なる場合があります」と回答します。

一方で、「ChatGPT+AEI」では具体的な労働基準法などをしっかりと照らし合わせた中で、ルール適合性チェックを行っていますので、「法令に基づくと、時間外労働割増賃金率は60時間以内の時間外労働に対しては25パーセント以上、60時間超に対しては50パーセント以上です」と回答します。

厳密に言うと、「ChatGPT」の返答は満点ではなく情報が欠落しており、評価は「△」です。一方で、「ChatGPT+AEI」は、きちんとルールに適合した中でしっかりと回答できるという例になります。

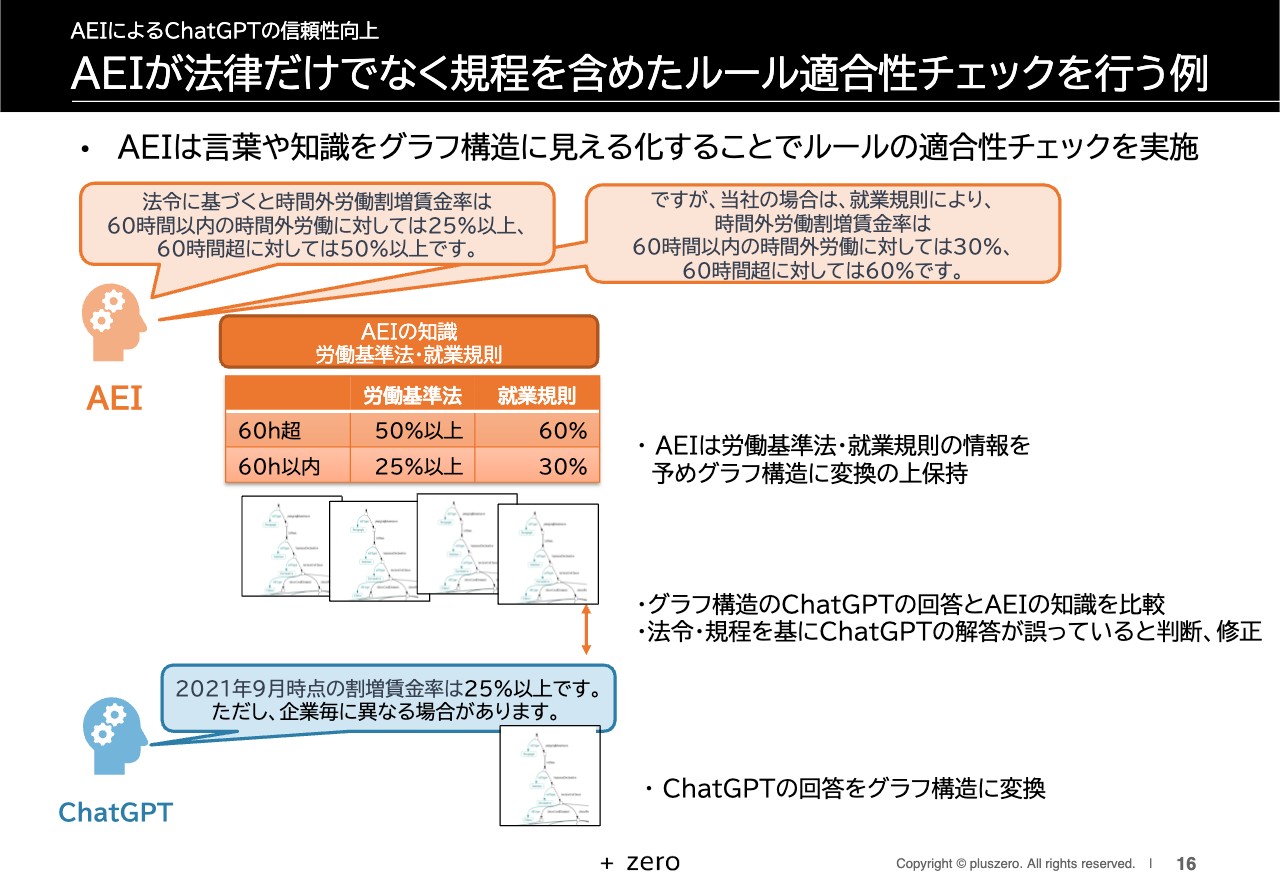

AEIが法律だけでなく規程を含めたルール適合性チェックを行う例

さらに細かいことを言うと、「ChatGPT」は「割増賃金率は25パーセントです」と回答しましたが、厳密には、労働基準法により50パーセント以上あるいは25パーセント以上という範囲を示しているだけです。

そのため、ある企業の就業規則では「60時間を超えた場合には60パーセント、60時間以内の場合は30パーセント」というかたちで、限定しているケースもあります。そのような時には、現場の一つひとつの違いに応じて回答しなければ、正確とは言えないのです。

先ほどの答えに合わせて法令に基づいたかたちにすると「しかし、当社の場合は就業規則により、具体的にこのようなかたちで定めています」と答えるのが、現場で通用する信頼性を備えた回答で、既存との違いをご理解いただけると思います。

ChatGPTはAEIの開発を加速させる

「ChatGPT」と「AEI」の関係については、「ChatGPT」が「AEI」の開発を加速させると考えています。具体的には、「AEI」に「ChatGPT」を組み込むようなケースや、「AEI」開発に「ChatGPT」を活用するようなケースが考えられると捉えています。

2つのケースについてそれぞれご説明します。1つ目は「対話のエンジンとしての利用」です。2023年4月時点で「AEI」には13の発話ロジックがあります。ディープラーニングを中心とした大規模言語モデルというのは、もともとその1つです。「ChatGPT」を中心に一気に進化してきているのですが、そのような発話ロジックの13分の1がより賢くなっていくことが、全体の追い風になると思っています。

2つ目は「PSFデータ整備の効率向上」です。知能を見える化したPSFデータのデータ整備のために活用することになっています。ただし、こちらは各サービス・モデルの利用規約等で定められていることもありますので、大規模言語モデル全般の活用を前提としています。

以上のことから、「ChatGPT」系のサービスや技術により、「AEI」の開発が加速していく関係になっているとご理解いただければと思います。

AEIは運用すればするほど、効率的に賢くなれる

「AEI」は、運用すればするほど効率的に賢くなります。意味や知能の見える化は非常に難易度が高く、その難易度が高いものを実現したからこそ、局所的に動的更新できます。

例えば、ディープラーニング系の技術で人材採用について検討した時に、人種差別が根強く残っていた時代のデータで人材採用を学習すると、人種差別する「AEI」が出来上がってしまいます。

一方で、「AEI」で人材採用のモデルを作るということであれば、「結果平等と機会平等の考え方があり、結果平等は必ずしも保証する必要はないが、機会平等に関しては積極的に保障していくべき」といったことをしっかりと言語化、ルール化できます。これらを人材採用に盛り込んでいくということであれば、局所的にそのルールを追加することによって、更新していけばよいというわけです。

2つ目の「明示的に推論できる」についてです。推論とは、既存の知識を使い新しい知識を作り出していくことですが、見える化したことで推論できるようになります。

ディープラーニングもデータを読み込むことによって汎化性能、未知のデータに対応していく力をある程度身につけていきますが、見える化された状態の中で、「何と何を組み合わせて、こうやって新しい知識を作る」という考えを、明示的につないでいけることが非常に有効です。

そのような意味で、動的更新をすればするほど賢くなっていきます。見える化された状態で、確実な知識に基づいた上でそれを組み合わせて、新しい知識を作り出していくことができます。これらを活かし、「AEI」は「ChatGPT」が実現している水準をさらに超えて、賢くなっていくことができると考えています。

冒頭にお話しした表のまとめです。「ChatGPT」と「AEI」を比較した時に、最初にお伝えしなければいけないのは、「ChatGPT」は非常に汎用性が高く、広範に適用できる技術であることです。

「AEI」は業界などのジャンルに特化し、信頼性を含めて人間のように賢くなれる技術です。特に業界拡大については、今期中から部分的にサービスを開始しますが、業界拡大が一気に加速するのは、2026年10月期以降を計画しています。

AIの性能については、精度と信頼性の2軸でお話ししました。ただし、3軸目として現場適用力があります。信頼性については今回開示していますが、現場適用力に関しては、競争戦略上で非常に重要なポイントですので、割愛させていただきました。

AIの性能という意味では、正解かどうかという精度と信頼性、そして現場にいかに適用できるかが重要になってきます。現在の「ChatGPT」の精度は一定以上高く保たれていますが、信頼性を高めるためにはさまざまな努力をして、ディープラーニングの外部機能を充実させて実現していくしかありません。

一定以上の精度になると、外部のほうが大規模言語モデル、ディープラーニングの機能次第となり、突き詰めると「AEI」になってしまうのです。見える化しなければ信頼性が高まらないため、もちろん努力していくことで「ChatGPT」の信頼性の部分が「△」が「〇」になっていくことは考えられるのですが、ディープラーニングの理論は、ブラックボックスが前提ですので、苦労し続けるものだと思っています。

そのため、今後も「AEI」と「ChatGPT」を組み合わせるようなかたちで信頼性を高めていくアプローチが、主流になっていくのではないかと考えています。

現場の適用力については、もちろん現場に依存するところもありますし、プラグインということで、「ChatGPT」の機能拡張が実現され、増加傾向にあります。現場ごとに機能拡張が増えていくのではないかと考えています。

一方で、先ほど割増賃金の例もお話ししましたが、「AEI」は業界に特化して現場に対応できる強みがあると考えています。

費用面に関しては、現在の目算として「ChatGPT」で1兆円を超えるような投資が入り、さらにそのレベルで投資が進んでいます。「AEI」については、今の見積もりで100分の1ほどのレベルで実現していけると思っていますので、費用面の優位性は、非常に高いのではないかと考えています。

開発の人材については、「ChatGPT」はディープラーニング系の技術ですので、微分を繰り返すような高等数学や、データを高レベルで扱う計算機科学などを扱う理系人材が中心となっていきます。

「AEI」は、意味を見える化していかなければいけません。もちろん理系人材も大事ですが、それ以外にも言語学や哲学、心理学などの文系分野も含めて、理系と文系の両方を高いレベルで理解しているチームで取り組まなければ、見える化のアプローチはうまくいきませんので、文理融合人材中心のアプローチになっていると考えています。

技術面については、「ChatGPT」は大規模言語モデルですが、「AEI」は意味の見える化が中心です。「意味の見える化」と「大規模言語モデル」といった組み合わせになっているとご理解いただければと思います。

参考文献

「ChatGPT」を中心とした2023年4月時点の調査の中で、特筆すべきポイントを参考文献等で記載していますので、こちらも参考にしていただければと思います。ご説明は以上です。ありがとうございました。

新着ログ

「情報・通信業」のログ